Google AlphaEarth : l’IA qui change la donne ?

Le 30 juillet dernier, Google lançait AlphaEarth Foundations, un modèle d’intelligence artificielle (IA) développé par Google DeepMind, annoncé comme une révolution pour la cartographie et l’observation de la Terre. Pierre angulaire de la stratégie Google Earth AI du géant de la tech, qui déploie l’IA pour des tâches d’analyse géospatiale variées, il fonctionnerait comme un satellite virtuel qui permet de cartographier le monde «à n’importe quel endroit et n’importe quand» avec une haute résolution. La promesse est belle… Mais est-elle tenue?

«Ce modèle d’IA s’inscrit parmi les modèles de fondation appliqués à la vision par ordinateur et à l’analyse d’image. Ces modèles généralistes peuvent être rapidement spécialisés pour des applications spécifiques (agriculture, forêt, occupation du sol, etc.) tout en nécessitant beaucoup moins de données annotées que les modèles entraînés de façon classique», indique Antoine Labatie, ingénieur de recherche IA au sein de l’Institut national de l’information géographique et forestière (IGN). L’apprentissage est dit «autosupervisé»: AlphaEarth Foundations est entraîné sur d’énormes volumes de données d’entrée mais demande peu d’interventions humaines et l’économie en coût d’annotations sur les tâches cibles rend cette approche globalement moins coûteuse.

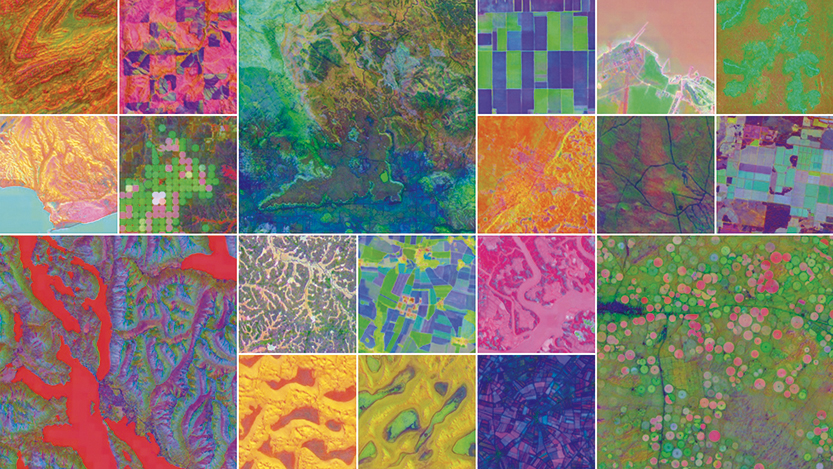

L’IA de Google compile des téraoctets d’informations issues de dizaines de sources publiques — images satellitaires multispectrales, radar et lidar, simulations climatiques, etc. — pour produire à la demande des cartes offrant un haut niveau de détails, utilisables dans des domaines tels que l’urbanisme, le suivi de l’environnement, de la déforestation et des cultures, la détection de changement ou la gestion de l’eau. Pour chaque pixel de 10m sur 10, les données multisource issues d’une année de suivi par satellite (Sentinel-1, Sentinel-2, Landsat…) sont «résumées» dans une représentation numérique unifiée (un vecteur) à 64 dimensions, chaque dimension encodant une caractéristique différente. Dénommée «embedding», cette représentation fournit une information dite sémantique, qui traduit le sens des données plutôt que d’être un simple reflet de la réalité physique.

DES ANALYSES PLUS ACCESSIBLES

«Google a réalisé un gros travail pour produire une information sémantique la plus complète possible dans un très petit vecteur», remarque Antoine Labatie. Selon Google DeepMind, les embeddings AlphaEarth utilisent seize fois moins d’espace de stockage que les systèmes comparables, tout en réduisant le taux d’erreur moyen de 24% sur les tâches cibles. Accessibles via la plateforme Google Earth Engine, les embeddings prédisent une information spatialisée à un instant T même en cas de manque de données ou d’annotations, d’où l’analogie avec un satellite virtuel. «Cette approche démocratise les analyses», considère Antoine Labatie.

L’IA de Google compile des données issues de dizaines de sources publiques. © Google DeepMind

L’IA de Google compile des données issues de dizaines de sources publiques. © Google DeepMind

Les performances du modèle sont saluées par Tasso Azevedo, fondateur du réseau de surveillance MapBiomas, qui teste ce jeu de données au Brésil pour suivre l’évolution des usages agricoles, comme par l’Australien Nicholas Murray, responsable scientifique de l’Atlas mondial des écosystèmes (Groupe intergouvernemental d’observation de la Terre). «Les acteurs qui veulent aller vite et manipuler le moins de données possible vont peut-être se tourner vers les embeddings. Mais il y a quand même une perte d’informations, et ceux qui veulent creuser continueront d’utiliser les données brutes ou, comme l’IGN, de produire leurs propres modèles d’IA», tempère l’ingénieur. AlphaEarth n’entre donc pas directement en concurrence avec les images aériennes ou les données lidar HD, plus riches en informations. «Ce sont des marchés différents», estime l’expert. Par ailleurs, l’information sémantique étant extraite des données brutes, celles-ci resteront toujours nécessaires.

«AlphaEarth induit une dépendance au portail Google Earth Engine qui soulève une question de souveraineté, poursuit-il. La pérennité de service n’est pas garantie et, bien que les recherches de Google soient partiellement ouvertes, la transparence n’est pas totale.» Si le géant de la Silicon Valley a poussé ses pions en premier, d’autres acteurs travaillent à leurs propres modèles, qui pourraient à terme offrir une alternative. «L’IGN envisage aussi de développer un modèle d’IA pour la France, qui s’inscrirait dans sa politique de promotion des “communs” et utiliserait notamment les données issues de ses programmes BDOrtho et LidarHD pour fournir une plus haute résolution», révèle Antoine Labatie.